Wie kann ich KI’s sicher und effizient mit Azure und OpenAI im Unternehmen nutzen?

Die KI-Landschaft entwickelt sich rasant, und die zunehmende Verwendung von Generative Pre-trained Transformer (GPT) wie ChatGPT und Googles Gemini ist

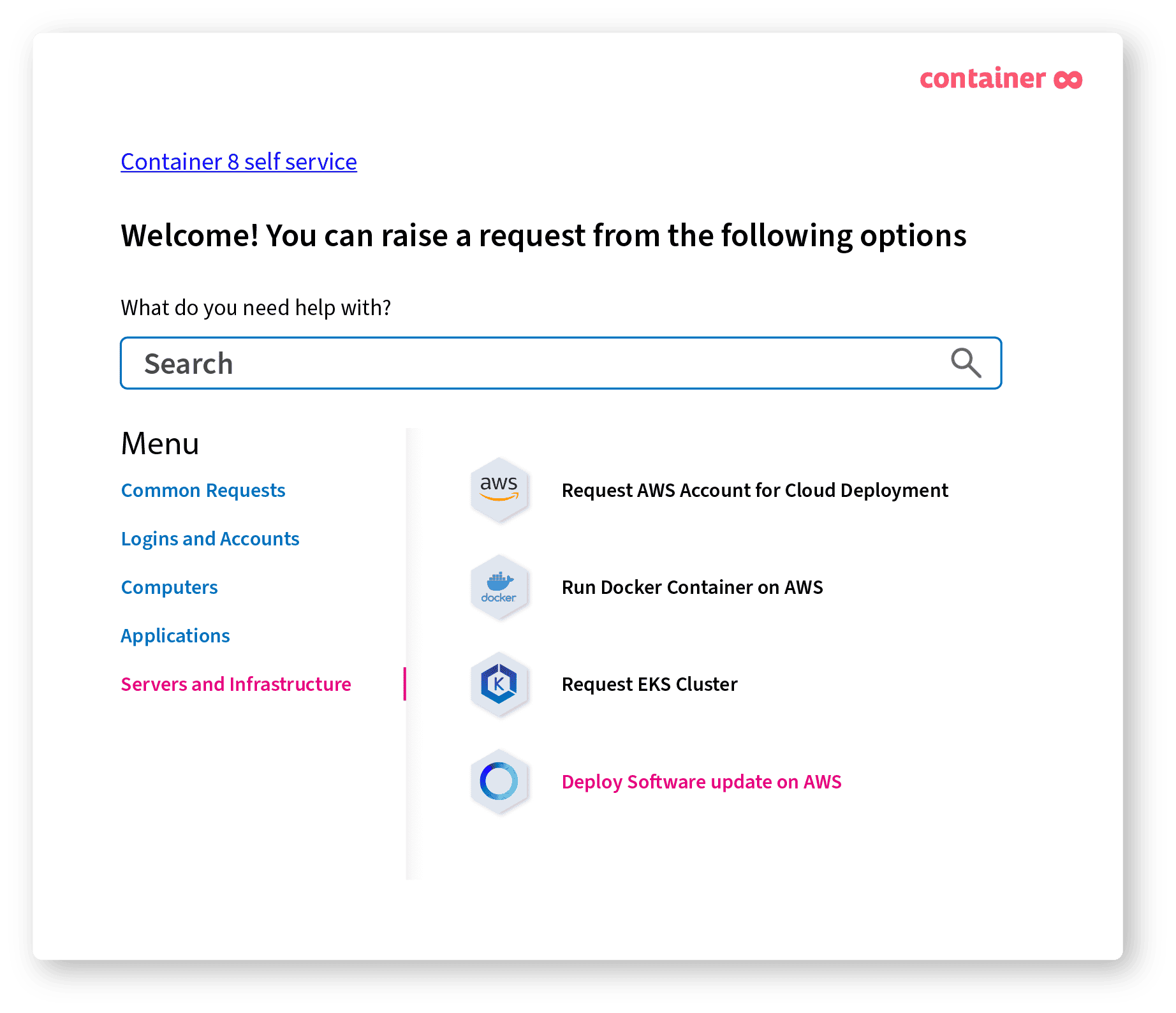

Gratis Webinar – AWS-Infrastruktur in wenigen Minuten mit JSM & Developer Self-Service aufsetzen

The DevOps self-service platform provides everything a developer needs to work autonomously and speed up go to market.

Confluence als Basis für Ihr Intranet, Knowledge Base und Kollaboration Platform – Flexibel einsetzbar, skalierbar und sicher.

Unsere Intranet Technologien:

Synchroniseren von Jira Issues, Anhängen, Kommentaren, Projekten und mehr über Unternehmensgrenzen hinaus.

Für Jira und Jira Service Management (Cloud und Data Center)

Meistern Sie die wachsenden Anforderungen an Ihrem Zugriffs- und Berechtigungs-Management in Jira und Confluence.

Um ein qualitativ hochwertiges Softwareprodukt auszuliefern, muss es stetig getestet und optmiert werden.

Beratung, Beschaffung und Management von Lizenzen für Ihre Atlassian Produkte.

Optimieren Sie Ihr IAM durch die nahtlose Integration von XAAM. Unser vollständig integriertes System ermöglicht es Ihnen, Rechte selbstständig über Jira Service Management anzufordern.

Entdecken Sie unser maßgeschneidertes Projektportfoliomanagement in Jira! Maximieren Sie Effizienz, beschleunigen Sie Entscheidungen und optimieren Sie Ressourcennutzung für Ihren Unternehmenserfolg.

Beschleunigen Sie Ihre Bewerbungsprozesse mit Jira und Jira Service Management und managen Sie Human Resources direkt in Ihren Atlassian Tools.

Die KI-Landschaft entwickelt sich rasant, und die zunehmende Verwendung von Generative Pre-trained Transformer (GPT) wie ChatGPT und Googles Gemini ist

Künstliche Intelligenz ist auf dem Vormarsch und erhält Einzug in alle Lebensbereiche, so auch in der Geschäftswelt. Auch Jira und

Als langjähriger Nutzer von Atlassian-Produkten können Sie sich sicher an die guten alten Server-Zeiten erinnern. Doch jetzt steht eine Veränderung

Lerne uns kennen und finde heraus wofür wir stehen und welche Vision XALT verfolgt.

Jung, divers und voller Energie. Du willst wissen, wer wir sind? Lern uns kennen.

Werde Teil unseres Teams und unserer Vision.

Das erwartet dich bei uns.

Entwicklung von Plugins, Addons & Apps für Ihre Atlassian Produkte – Individuell auf Ihre Anforderungen zugeschnitten.

Erweitern Sie Ihr Jira und Confluence mit unseren Plugins.

Visuelle Power für Ihre Inhalte in Confluence. Slider, Masonry und Bilder Galerien für Ihre Confluence Seiten.

Strukturierung und Gruppierung von Inhalten in mehreren, individuellen Tabs innerhalb von Confluence.

Beschleunigen Sie die Markteinführung digitaler Produkte, verbessern Sie die Ausfallsicherheit Ihrer IT-Infrastruktur und ermöglichen Sie Ihren Produkt-Teams Innovationen zu fördern.

Success Story: Projektportfoliomanagement und Ressourcenplanung mit Jira Ergebnis 50% weniger Planungsaufwand für Projektmanager Warum Portfoliomanagement? Projektportfoliomanagement ist der Prozess der…

Die KI-Landschaft entwickelt sich rasant, und die zunehmende Verwendung von Generative Pre-trained Transformer (GPT) wie ChatGPT und Googles Gemini ist…

Künstliche Intelligenz ist auf dem Vormarsch und erhält Einzug in alle Lebensbereiche, so auch in der Geschäftswelt. Auch Jira und…

Als langjähriger Nutzer von Atlassian-Produkten können Sie sich sicher an die guten alten Server-Zeiten erinnern. Doch jetzt steht eine Veränderung…

Confluence ist eines dieser Tools, das so ziemlich alles Mögliche kann. Du kannst Dokumentationen für deine User und Projekte bereitstellen,…

Das Jahr 2024 hält für Atlassian und seine Anwender einige bedeutende Veränderungen und aufregende Neuerungen bereit. Lassen Sie uns einen…

Wusstest du, dass Projektportfoliomanagement (PPM) eine wichtige Rolle für den Erfolg von Unternehmen spielt? Es ist ein wertvolles Instrument für…

Die Vorteile von Cloud Services sind bekannt und werden mittlerweile in unzähligen Praxisbeispielen nachgewiesen. Dennoch zögern manche Unternehmen damit ihren Umstieg in die Cloud voranzutreiben.

Die KI-Landschaft entwickelt sich rasant, und die zunehmende Verwendung von Generative Pre-trained Transformer (GPT) wie ChatGPT und Googles Gemini ist…

Künstliche Intelligenz ist auf dem Vormarsch und erhält Einzug in alle Lebensbereiche, so auch in der Geschäftswelt. Auch Jira und…

Als langjähriger Nutzer von Atlassian-Produkten können Sie sich sicher an die guten alten Server-Zeiten erinnern. Doch jetzt steht eine Veränderung…

Die Welt der IT ist im Wandel. Technologische Neuerungen erfordern immer schnellere Anpassungen und eine agile Arbeitsweise um den Anschluss an Ihre Mitwettbewerber nicht zu verpassen. Wir bei XALT haben uns es deshalb zur Aufgabe gemacht, Sie auf Ihrem Weg in die Digitale Transformation zu begleiten und mit unseren maßgeschneiderten IT-Lösungen nachhaltig zu Ihrem Unternehmenserfolg beizutragen.

Atlassian Expertise und Agile Transformation mit XALT

Wir unterstützen Ihr Unternehmen bei der effizienteren Verwendung Atlassian Tools wie Jira und Confluence.

Und beraten Sie, wie Sie zu:

Gemeinsam mit Ihnen modernisieren wir das Hosting Ihrer Apps in der Cloud und Ihre IT-Infrastruktur, um Agilität, Produktivität und Effizienz zu steigern und gleichzeitig Risiken durch Systemausfälle zu reduzieren.

Als Atlassian, AWS und Azure Partner beraten wir Sie basierend auf Ihren Anforderungen bei der Auswahl der richtigen Technologie zur Migration in die Cloud (z.B. Cloud Native AWS Umgebung oder Atlassian Cloud).

Als Software Unternehmen stehen Sie täglich vor der Herausforderung Ihren Usern die bestmögliche Erfahrung zu bieten.

DevOps befähigt Ihr Team Software schneller und zuverlässiger zu entwickeln, zu testen und zu veröffentlichen und darüberhinaus Ihre IT-Infrastruktur effizient bereitzustellen.

Wir beraten Sie in den Themen:

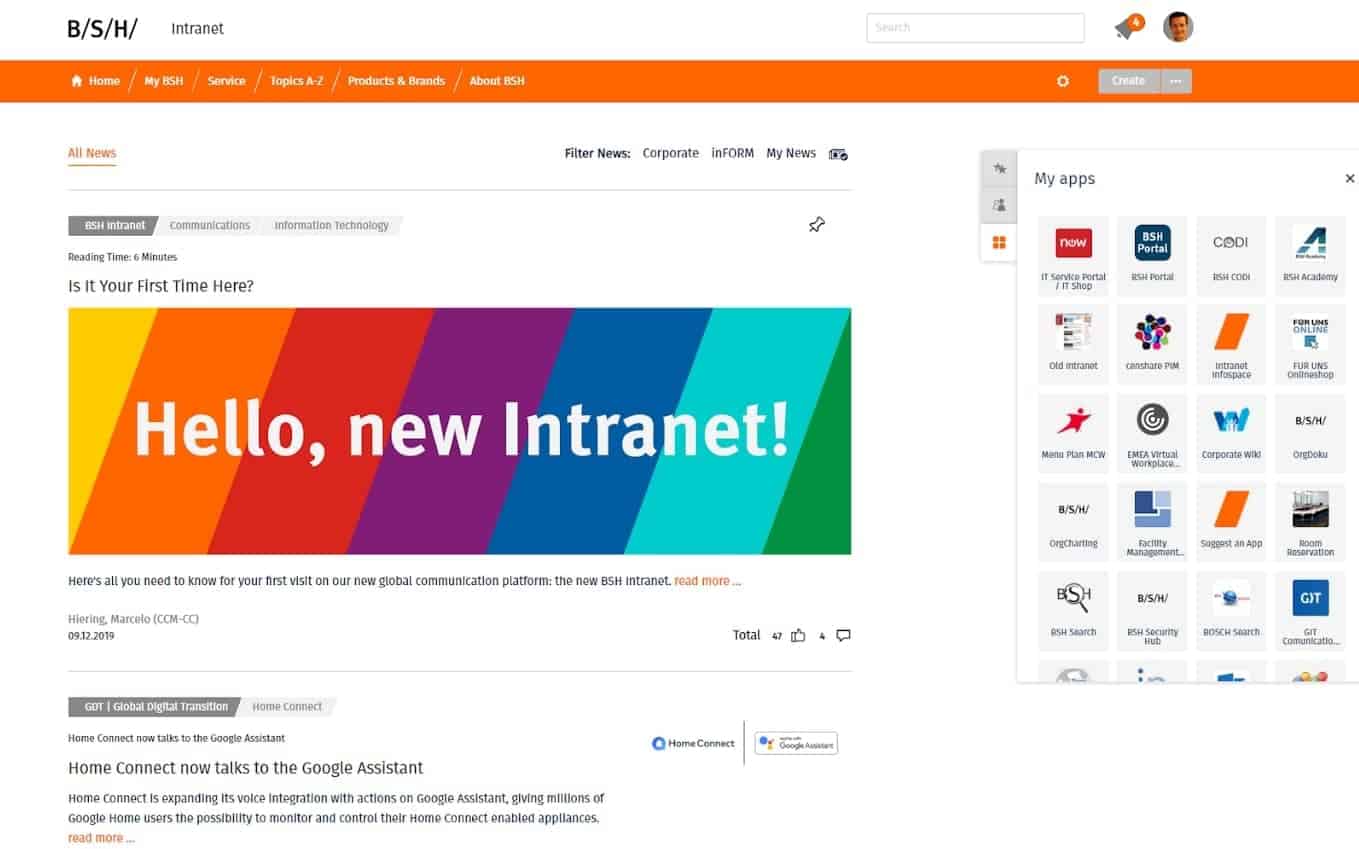

Unsere Lösung zur Stärkung Ihrer internen Kommunikation

Als Unternehmen sind Sie stets auf der Suche Möglichkeiten, die interne Kommunikation zu verbessern und Ihren MitarbeiterInnen Tools zur Verfügung zu stellen um sich untereinander austauschen und wichtige Informationen stets abrufen zu können.

Ein Intranet auf Basis von Confluence ist hierfür der ideale Ausgangspunkt.

Ineffiziente und schwere Prozesse bremsen Ihr Unternehmen aus, führen zu Frust in Ihrer Belegschaft und verschlingen Unmengen von Zeit.

Zusammen mit Jira lassen sich Ihre analogen Prozesse Digitalisieren und wiederkehrende Aufgaben mithilfe von Automatismen in Ihren Workflows beschleunigen.

So haben Ihre Mitarbeiter mehr Zeit für Tasks, die Ihr Unternehmen wirklich voranbringen.

Container8 ist eine hoch automatisierte und ressourcenschonende DevOps-as-a-Service-Plattform, die Ihre vorhandenen Tools integriert oder ein von uns verwaltetes Toolset bereitstellt, um die DevOps Methodologie in Ihren Teams fest zu etablieren.

Container8 versetzt Ihre Softwareteams in die Lage, Software, Updates oder Bugfixes schneller, häufiger und unabhängiger zu veröffentlichen. Mit Container8 können sie die Komplexität einer selbstverwalteten DevOps-Plattform erheblich reduzieren und die Performance der am Produkt beteiligten Team erheblich steigern.

Weitere Lösungen finden Sie hier

Ist Ihre IT noch sicher durch den technologischen Wandel in modernen Arbeitsplatzumgebungen?

In diesem Whitepaper beleuchten wir den aktuellen Stand der Arbeitsplatzsicherheit, die Grundprinzipien des Zero-Trust-Sicherheitsmodells und wie Sie eine sichere Arbeitsplatzumgebung aufbauen.

Wir unterstützen Unternehmen und Institutionen bei der Einführung und Entwicklung von agilen IT-Lösungen. In unseren Customer Stories lässt sich nachlesen, wie die praktische Umsetzung von DevOps-Konzepten sowie von Atlassian-Projekten aussieht. Im Mittelpunkt steht für uns hierbei immer der Nutzen und die Zufriedenheit unserer Kunden.

Weitere Success Stories finden Sie hier

Als erfahrene Projekt Co-Piloten unterstützen und begleiten wir unsere Kunden von Beginn an auf ihrer Reise, bis diese sicher und erfolgreich ihr angestrebtes Ziel erreicht haben.

Jira und Confluence sind fester Bestandteil Ihres Workflows, Kommunikation und Projektmanagement? Sie möchten herausfinden, welche Stellschrauben zu drehen sind, um die Anwendungen noch besser auf Ihre Bedürfnisse auszurichten?

Seit 2016 helfen und begleiten wir IT-Teams auf ihrem Weg zur Umsetzung von DevOps-Methoden, Cloud-Konzepten und agilen Workflows. Unsere Grundüberzeugung ist, gemeinsam mit dem Kunden zu wachsen. Wir fördern den gegenseitigen Wissensaustausch und arbeiten von der ersten Minute an auf einer persönlichen Ebene zusammen. Damit entfesseln wir das volle Potenzial von IT-Teams und schaffen agile, innovative Lösungen.

Vom Atlassian Berater bis hin zum Designer

Unser Team wächst stetig und setzt sich aus KollegInnen mit unterschiedlichsten Fähigkeiten und beruflichen Werdegängen zusammen. Bei uns wird Diversität, Individualität und Gleichberechtigung in allen Formen gefördert und wertgeschätzt.

Wir stehen immer zur Verfügung, um sich über die neuesten Trends bezüglich Software Entwicklung, DevOps, Cloud Systeme und Digitale Transformation auszutauschen. Schicken Sie uns gerne eine kurze Nachricht, oder vernetzen Sie sich mit uns über Social Media.

Your project co-pilot

Die BSH Hausgeräte GmbH ist der größte Hersteller von Haushaltsgeräten in Europa und eines der weltweit führenden Unternehmen in dieser Branche.

Sed ut perspiciatis unde omnis iste natus error sit voluptatem accusantium doloremque laudantium, totam rem aperiam.